Le personnage 3D occupe aujourd’hui une place singulière dans l’écosystème de la création numérique. Il n’est plus seulement l’avatar d’un joueur ou la marionnette d’un animateur : il est devenu le point nodal où convergent les arts visuels, la technique informatique, la narration interactive et, désormais, l’intelligence artificielle générative.

Du héros de jeu vidéo AAA aux influenceurs virtuels qui accumulent des millions de followers, de l’humain numérique photoréaliste des productions Netflix aux avatars stylisés du métavers, le personnage 3D traverse les industries avec une fluidité inédite. Il structure le game design, porte l’émotion du cinéma d’animation, incarne l’identité numérique des utilisateurs de mondes virtuels, et s’imprime désormais en résine sur les bureaux des collectionneurs.

Mais derrière cette omniprésence se cache une réalité technique exigeante. Créer un personnage 3D exploitable en production — c’est-à-dire animable, texturé, optimisé et exportable vers différentes plateformes — mobilise un ensemble de compétences qui s’étend bien au-delà de la simple sculpture numérique. C’est un artisanat à part entière, où la maîtrise anatomique rencontre la contrainte du polycount, où l’expression artistique compose avec les impératifs du rigging.

Ce guide se propose de cartographier l’ensemble des approches, outils et méthodologies disponibles pour créer des personnages 3D. Que vous soyez artiste indépendant explorant une solution 3D pour la première fois, professionnel cherchant à intégrer de nouveaux outils à votre pipeline, ou curieux des bouleversements qu’apporte l’IA générative au métier, vous trouverez ici une vision globale et technique du sujet.

Qu’est-ce qu’un personnage 3D exactement ?

Avant de s’intéresser aux techniques de création, il est essentiel de définir ce qui constitue un « vrai » personnage 3D exploitable en production. Car un modèle spectaculaire en rendu statique peut se révéler inutilisable dès qu’on tente de l’animer ou de l’intégrer dans un moteur de jeu.

Un personnage 3D complet se compose de plusieurs couches interdépendantes, chacune répondant à des exigences techniques précises.

Le modèle (mesh)

Le mesh constitue la géométrie du personnage : l’ensemble des vertices, edges et faces qui définissent sa forme dans l’espace tridimensionnel. Ce maillage polygonal peut compter quelques centaines de triangles pour un personnage mobile stylisé, ou plusieurs millions pour un humain numérique de cinéma. La densité du mesh détermine directement le niveau de détail géométrique et les contraintes de performance.

La topologie

La topologie désigne l’organisation structurelle du mesh : comment les polygones s’agencent, où se situent les boucles d’arêtes (edge loops), comment les déformations se propagent lors de l’animation. Une topologie optimisée utilise principalement des quads (polygones à quatre côtés), qui subdivisent proprement et se déforment de manière prévisible. Les triangles sont tolérés dans certaines zones, les n-gons (polygones à plus de quatre côtés) sont à proscrire sur les modèles destinés à l’animation.

L’edge flow — le flux des arêtes à travers le mesh — doit suivre les lignes naturelles du corps et du visage : les muscles, les articulations, les zones d’expression. Un edge flow mal conçu provoque des déformations aberrantes, des artefacts de shading, des difficultés de rigging impossibles à corriger sans reprendre la topologie depuis le début.

Les UV

Les UV représentent le dépliage bidimensionnel du modèle 3D, permettant d’appliquer des textures sur sa surface. Imaginez qu’on découpe la peau du personnage et qu’on l’étale à plat : c’est le principe de l’unwrap UV. La qualité de ce dépliage conditionne directement celle des textures : des UV mal répartis créent des étirements, des distorsions, des coutures visibles.

En production professionnelle, les UV sont organisés en UDIM (multiple UV tiles) pour les projets haute résolution, ou optimisés en atlas unique pour les assets temps réel.

Les matériaux et textures

Les matériaux définissent comment la surface du personnage réagit à la lumière. Dans un workflow PBR (Physically Based Rendering), devenu le standard de l’industrie, plusieurs maps travaillent ensemble : albedo (couleur de base), roughness (rugosité), metallic, normal map (détails de surface), ambient occlusion, et potentiellement subsurface scattering pour la peau.

Ces textures sont généralement créées dans des logiciels spécialisés comme Substance Painter ou Mari, à partir des maps bakées depuis le modèle high-poly.

Le rig

Le rig constitue le squelette du personnage : un système d’os (bones) et de contrôleurs permettant de le poser et de l’animer. Un rig de qualité professionnelle inclut le squelette principal (spine, membres, tête), un système de facial rigging pour les expressions, des contrôleurs IK/FK pour les membres, des blend shapes ou morph targets pour les déformations faciales, et potentiellement des systèmes de muscles et de simulation de vêtements.

Le skinning — l’association du mesh aux bones avec des poids d’influence — détermine comment la géométrie se déforme lors des mouvements. C’est l’une des étapes les plus chronophages et les plus difficiles à maîtriser.

La pose

Un personnage livré en T-pose ou A-pose (bras écartés) facilite le rigging et le skinning. Mais pour la présentation portfolio ou les assets de bibliothèque, une pose d’action ou d’expression révèle le potentiel du personnage bien mieux qu’une posture neutre.

Ces six composantes — mesh, topologie, UV, matériaux, rig, pose — forment le socle technique de tout personnage 3D professionnel. L’absence ou la défaillance de l’une d’entre elles compromet l’ensemble du pipeline.

La modélisation polygonale classique

La modélisation polygonale reste le socle historique de la création 3D. Avant l’avènement du sculpting numérique, c’était l’unique méthode pour construire des personnages — et elle demeure incontournable pour certaines étapes du pipeline, notamment la retopologie et la création de meshes optimisés.

Les principes fondamentaux

Modéliser en polygones, c’est manipuler directement les composants géométriques : déplacer des vertices, extruder des faces, insérer des edge loops, souder des éléments. Cette approche offre un contrôle absolu sur la topologie, mais exige une vision claire de la structure finale dès les premières étapes.

L’edge flow en modélisation polygonale doit anticiper deux contraintes majeures : la déformation lors de l’animation et le comportement au subdivision. Les boucles d’arêtes doivent encercler les zones de flexion (coudes, genoux, épaules) et suivre les muscles du visage (orbiculaires des yeux et de la bouche, muscles zygomatiques).

La règle d’or : privilégier les quads. Les faces à quatre côtés se subdivisent de manière prévisible, se déforment uniformément, et simplifient l’UV mapping. Les triangles peuvent être placés stratégiquement dans des zones de faible déformation. Les n-gons sont à bannir absolument des modèles destinés à l’animation.

L’approche anatomique

Modéliser un personnage humain ou humanoïde exige une connaissance solide de l’anatomie — au minimum les proportions générales, idéalement la structure musculaire sous-jacente. Les artistes professionnels travaillent avec des références anatomiques constantes : écorchés, planches musculaires, photos de modèles vivants.

La construction commence généralement par un blockout — des formes primitives assemblées pour établir les proportions globales — avant de raffiner progressivement les volumes et d’ajouter les détails secondaires.

Les outils de modélisation polygonale

Blender s’est imposé comme la référence open source. Son mode Edit offre un arsenal complet d’outils de modélisation polygonale : extrude, bevel, loop cut, knife, bridge, merge. L’addon HardOps et BoxCutter excellent pour le hard surface, tandis que les modifiers (Mirror, Subdivision Surface, Shrinkwrap) accélèrent considérablement le workflow.

Maya reste le standard de l’industrie du film et du jeu AAA. Son Modeling Toolkit et l’outil Quad Draw pour la retopologie sont particulièrement appréciés des professionnels. L’intégration avec le reste du pipeline Autodesk (MotionBuilder, 3ds Max) en fait un choix logique pour les studios.

3ds Max conserve une base d’utilisateurs fidèles, notamment dans l’architecture et le jeu vidéo. Ses modifiers empilables (Edit Poly, Turbosmooth, Symmetry) et son écosystème de plugins (Forest Pack, RailClone) lui confèrent une polyvalence appréciable.

Avantages et limites

La modélisation polygonale excelle là où le contrôle topologique est primordial : création de meshes game-ready, retopologie de sculpts, hard surface, éléments mécaniques ou stylisés. Elle permet de maîtriser exactement le nombre de polygones et leur placement.

En revanche, elle devient laborieuse pour les formes organiques complexes et les détails fins (pores de peau, rides, cicatrices). Le sculpting numérique s’impose alors comme complément naturel.

Le sculpting

Le sculpting numérique a transformé la création de personnages 3D. En émulant le geste du sculpteur traditionnel — pousser, tirer, lisser, creuser la matière — il a rendu accessible la création de formes organiques d’une complexité autrefois réservée aux studios disposant de budgets conséquents.

Le paradigme high-poly

Contrairement à la modélisation polygonale qui travaille avec des meshes relativement légers, le sculpting opère sur des modèles de plusieurs millions de polygones. Cette densité permet de modeler directement les détails les plus fins : pores de la peau, rides d’expression, fibres musculaires, textures de vêtements.

Le workflow typique progresse par niveaux de détail : d’abord les grandes formes (primary forms), puis les volumes secondaires (muscles, plis majeurs), enfin les micro-détails (pores, cicatrices, imperfections). Cette approche — souvent résumée par « big to small » — garantit des proportions justes avant d’investir du temps dans les finitions.

ZBrush : le standard industriel

ZBrush domine le marché du sculpting professionnel depuis deux décennies. Son moteur propriétaire gère des dizaines de millions de polygones en temps réel, permettant un niveau de détail inaccessible aux autres logiciels.

Les outils clés de ZBrush pour la création de personnages incluent DynaMesh (remeshing dynamique pour le blockout), ZRemesher (retopologie automatique), les alphas et VDM (Vector Displacement Mesh) pour les détails, le Polypaint pour la texture directe sur le mesh, et les SubTools pour organiser les différentes parties du personnage.

La version 2024 a considérablement amélioré l’algorithme DynaMesh pour une meilleure préservation des détails, et ZRemesher propose désormais une retopologie simultanée de plusieurs subtools.

Blender Sculpt : l’alternative open source

Le mode Sculpt de Blender a fait des progrès spectaculaires ces dernières années. Les performances ont été multipliées grâce au multithreading et à l’optimisation GPU. Les brushes (Clay Strips, Crease, Inflate, Grab) rivalisent désormais avec ceux de ZBrush pour la plupart des usages.

L’avantage majeur de Blender réside dans son intégration : le sculpt, la retopologie, l’UV mapping, le texturing et le rendu coexistent dans le même environnement. Pour un artiste indépendant, cette unification du pipeline représente un gain de temps et d’argent considérable.

Retopologie : du high-poly au production-ready

Un sculpt high-poly de 20 millions de polygones ne peut pas être directement utilisé en production. Il doit être converti en mesh « low-poly » (quelques dizaines de milliers de polygones pour un personnage de jeu) avec une topologie propre, optimisée pour l’animation.

La retopologie consiste à recréer manuellement ou semi-automatiquement un nouveau mesh par-dessus le sculpt, en respectant les règles de l’edge flow. Des outils comme Quad Draw (Maya), RetopoFlow (Blender), ou TopoGun automatisent partiellement ce processus, mais le placement des loops critiques reste un travail manuel exigeant.

Baking : transférer les détails

Une fois le mesh low-poly créé et ses UV dépliés, le baking permet de transférer les détails du high-poly vers des texture maps. La normal map encode les variations de surface sous forme de vecteurs, créant l’illusion de détails géométriques sans polygones supplémentaires. L’ambient occlusion map capture les ombres de contact. Le curvature map identifie les arêtes et les creux.

Substance Painter, Marmoset Toolbag et xNormal sont les outils de prédilection pour le baking. La qualité du résultat dépend crucialement de la correspondance entre high-poly et low-poly, et du paramétrage du « cage » (enveloppe de projection).

Modifier et adapter des assets existants

Tous les personnages 3D ne partent pas d’une page blanche. Dans de nombreux contextes de production — prototypage rapide, projets à budget limité, création de PNJ secondaires — la modification d’assets existants représente une approche parfaitement légitime et économiquement rationnelle.

Le kitbashing appliqué aux personnages

Le kitbashing, technique héritée du maquettisme physique (les décors de Star Wars en sont l’exemple canonique), consiste à assembler des composants préexistants pour créer de nouvelles formes. Appliqué aux personnages 3D, il permet de combiner des éléments d’armures, d’équipements, d’accessoires provenant de différentes bibliothèques.

Des éditeurs comme KitBash3D proposent des kits thématiques (sci-fi, fantasy, cyberpunk) utilisés par les plus grands studios. Les artistes de concept les assemblent pour valider des directions artistiques avant d’investir dans une modélisation sur mesure.

Les base meshes : point de départ optimisé

Les base meshes sont des modèles de personnages génériques, déjà topologisés et souvent riggés, destinés à servir de fondation. Plutôt que de modeler un corps humain depuis zéro, l’artiste importe un base mesh qu’il déforme ensuite selon ses besoins dans ZBrush ou Blender.

Les avantages sont considérables : gain de temps sur l’anatomie de base, topologie éprouvée pour l’animation, proportions cohérentes. De nombreux artistes professionnels ont développé leurs propres base meshes qu’ils réutilisent de projet en projet.

Avantages en production

La modification d’assets existants accélère drastiquement certaines phases de production. Pour un jeu comportant des dizaines de personnages secondaires, créer chacun from scratch serait économiquement prohibitif. Les studios utilisent des systèmes modulaires : un même squelette, quelques morphologies de base, des dizaines de variations vestimentaires et capillaires.

Cette approche modulaire structure également les bibliothèques de personnages commerciaux : les utilisateurs assemblent des combinaisons uniques à partir de composants standardisés.

Les écueils à éviter

Plusieurs problèmes récurrents guettent l’utilisateur d’assets tiers. L’incohérence stylistique survient lorsqu’on mélange des éléments de provenances diverses : différences de densité polygonale, de style de texturing, de conventions de naming. Le résultat trahit son assemblage hétéroclite.

Les questions de licence méritent une attention particulière. Certains assets sont « royalty-free » pour un usage commercial, d’autres sont strictement personnels. Les conditions de modification et de redistribution varient. Un audit rigoureux des licences s’impose avant toute utilisation professionnelle.

Enfin, la dépendance excessive aux assets commerciaux peut brider le développement des compétences fondamentales. L’artiste qui ne sait créer que par assemblage se trouvera démuni face à un brief nécessitant une création originale.

Génération et création assistée par IA

L’irruption de l’intelligence artificielle générative dans la création 3D constitue probablement la transformation la plus significative du domaine depuis l’avènement du sculpting numérique. En quelques mois, des outils capables de générer des modèles 3D à partir de prompts textuels ou d’images 2D sont passés du stade expérimental à une utilisation en production.

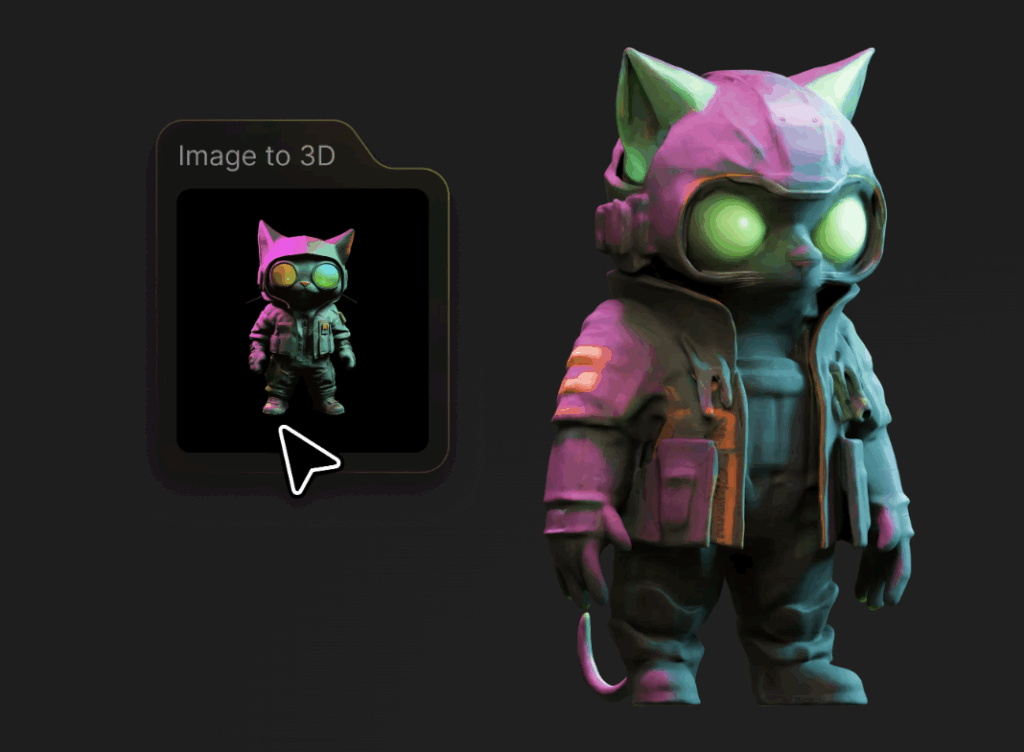

De l’image 2D au modèle 3D

Les plateformes comme Tripo AI, Meshy, Luma AI Genie et Rodin (Hyper3D) proposent un workflow apparemment magique : uploadez une image ou décrivez votre personnage en quelques mots, et recevez un modèle 3D texturé en quelques secondes.

Tripo 3.0, lancé fin 2024, revendique une topologie « production-ready » avec des options de génération en mode standard ou ultra (jusqu’à 2 millions de polygones). La plateforme intègre désormais l’export en T-pose avec squelette, facilitant l’intégration dans les pipelines d’animation.

Meshy se distingue par ses capacités de texturing automatique et son mode « Hard Surface » optimisé pour les objets techniques. Rodin Gen-1.5 propose des options de topologie quad et excelle sur les visages humains.

Limitations techniques actuelles

Malgré des progrès spectaculaires, les modèles générés par IA présentent des limitations récurrentes qui restreignent leur usage en production professionnelle.

La topologie reste problématique. Même les outils les plus avancés produisent des meshes dont l’edge flow ne respecte pas les conventions de l’animation. Les zones de déformation (articulations, visage) présentent souvent une densité polygonale inadaptée ou des flux d’arêtes incohérents. Une retopologie manuelle reste généralement nécessaire.

Les détails fins souffrent d’approximations. La face arrière des modèles (non visible sur l’image source) est « inventée » par l’IA avec des résultats variables. Les éléments symétriques présentent des asymétries, les accessoires complexes fusionnent parfois avec le corps.

L’intégration dans un pipeline existant pose des défis. Les conventions de naming, d’orientation, d’échelle varient d’un générateur à l’autre. Les textures, souvent impressionnantes visuellement, ne séparent pas toujours correctement les channels PBR.

Cas d’usage réalistes en production

Dans l’état actuel de la technologie, l’IA générative 3D trouve sa place dans plusieurs contextes spécifiques.

Le prototypage rapide bénéficie énormément de ces outils. Générer dix variations d’un personnage en quelques minutes permet de valider une direction artistique avant d’investir des jours de travail manuel. Les concept artists intègrent ces modèles dans des keyframes 3D pour les pitchs et les prévisualisations.

Les assets secondaires et de remplissage (foule, PNJ distants, éléments d’arrière-plan) peuvent utiliser des modèles générés avec un nettoyage minimal. Pour un personnage visible trois secondes à vingt mètres de la caméra, l’investissement d’une modélisation sur mesure n’est pas justifié.

L’exploration créative s’enrichit de la capacité à matérialiser rapidement des idées. Un character designer peut générer des dizaines de variations pour identifier des pistes intéressantes qu’il développera ensuite manuellement.

En revanche, les personnages principaux, les assets destinés au merchandising, les modèles nécessitant une animation faciale complexe continuent d’exiger une création traditionnelle ou, au minimum, une reprise substantielle des outputs IA.

Outils spécialisés de création de personnages

Entre la modélisation manuelle intégrale et la génération IA, une catégorie d’outils occupe un territoire intermédiaire : les logiciels spécialisés dans la création de personnages humains ou humanoïdes. Ces applications proposent des systèmes paramétriques permettant de « composer » un personnage à partir de curseurs, de morphes et de bibliothèques d’assets.

Daz Studio

Daz Studio s’est imposé comme la référence de la création de personnages accessible. Le logiciel lui-même est gratuit ; le modèle économique repose sur un marketplace foisonnant de morphes, vêtements, cheveux, poses et environnements.

Les figures Genesis (actuellement Genesis 9) constituent la base du système : des personnages entièrement paramétrables via des curseurs contrôlant chaque aspect de la morphologie. L’écosystème de contenus tiers est immense, permettant une personnalisation quasi illimitée.

Daz Studio excelle pour l’illustration statique et les rendus Iray intégrés. Ses limites apparaissent en animation : l’export vers des logiciels tiers nécessite des manipulations parfois laborieuses, et les morphes HD ne sont pas toujours supportés.

Character Creator 5

Character Creator 5 (CC4) de Reallusion adopte une philosophie différente : l’accent est mis sur l’animation et l’interopérabilité. Les personnages sont conçus pour s’intégrer dans des pipelines professionnels, avec des exports propres vers Unreal Engine, Unity, Blender et Maya.

CC4 propose un système de texturing basé sur Substance, permettant une personnalisation fine des matériaux (maquillage, rides, bronzage) avec export des maps PBR. L’intégration avec iClone (le logiciel d’animation de Reallusion) et le support du motion capture en font un choix privilégié pour les productions orientées animation.

Le modèle économique combine abonnement logiciel et marketplace d’assets, avec des prix généralement plus élevés que Daz mais une qualité production-ready plus constante.

MetaHuman Creator

MetaHuman Creator d’Epic Games représente l’approche la plus spectaculaire en termes de réalisme. Cet outil cloud génère des humains numériques photoréalistes à partir d’une interface de morphing, avec un niveau de détail facial inégalé (pores, micro-imperfections, subsurface scattering).

Les MetaHumans sont optimisés pour Unreal Engine 5 et tirent parti de Nanite (virtualisation de la géométrie) et Lumen (illumination globale temps réel). Leur intégration native avec le Control Rig d’Unreal permet une animation faciale d’une finesse remarquable.

La principale limitation reste l’écosystème fermé : les MetaHumans sont difficilement exportables hors d’Unreal. Pour des projets multi-plateforme ou des rendus dans d’autres moteurs, cette dépendance pose problème. Epic a annoncé des améliorations de l’interopérabilité, mais l’outil reste fondamentalement lié à son moteur.

MakeHuman

MakeHuman, projet open source, propose une alternative gratuite pour la création de base meshes humains. L’interface paramétrique permet de générer rapidement des morphologies variées, avec export vers les principaux formats 3D.

La qualité des modèles est inférieure aux solutions commerciales, mais MakeHuman reste pertinent pour l’apprentissage, le prototypage, ou comme point de départ pour un sculpting personnalisé. Le développement communautaire a ralenti ces dernières années face à la concurrence.

Tableau comparatif

| Outil | Force principale | Limite principale | Prix |

|---|---|---|---|

| Daz Studio | Écosystème d’assets massif | Export animation complexe | Gratuit + marketplace |

| Character Creator 5 | Pipeline animation pro | Coût élevé | Abonnement ~200$/an |

| MetaHuman | Réalisme facial inégalé | Verrouillé Unreal | Gratuit (avec UE) |

| MakeHuman | Open source, gratuit | Qualité limitée | Gratuit |

Pipeline professionnel d’un personnage 3D

La création d’un personnage 3D professionnel suit un pipeline structuré où chaque étape nourrit la suivante. Comprendre cette séquence — et ses nombreuses boucles de rétroaction — permet d’anticiper les problèmes et d’optimiser son workflow.

1. Concept et références

Tout commence par la définition visuelle du personnage. Un concept art détaillé — idéalement avec vues de face, profil et trois-quarts — sert de feuille de route. Les artistes professionnels compilent également un mood board de références : anatomie, matériaux, éclairage, style de rendu visé.

PureRef est devenu l’outil standard pour organiser ces références, permettant de les afficher en overlay pendant le travail.

2. Blockout / Modélisation de base

Le blockout établit les proportions et les grandes masses du personnage à partir de formes simples. Cette étape est cruciale : des proportions incorrectes à ce stade se répercutent sur l’ensemble du projet. Mieux vaut passer du temps sur un blockout juste que de corriger un sculpt avancé.

En ZBrush, DynaMesh ou ZSpheres permettent un blockout rapide. En Blender ou Maya, on assemble des primitives qu’on déforme progressivement.

3. Sculpting haute résolution

Une fois les proportions validées, le sculpting affine les formes et ajoute les détails. Le workflow progresse du général au particulier : grandes masses musculaires, puis volumes secondaires (tendons, veines), enfin micro-détails (pores, cicatrices).

Pour les vêtements et tissus, Marvelous Designer permet de simuler des drapés réalistes qu’on importe ensuite dans ZBrush pour les affiner.

4. Retopologie

Le sculpt high-poly est converti en mesh low-poly avec une topologie animation-ready. Les edge loops doivent encercler les zones de déformation, la densité polygonale doit être distribuée selon l’importance des détails et des mouvements.

Cette étape mobilise des outils comme Quad Draw (Maya), RetopoFlow (Blender), ou TopoGun. La retopologie manuelle reste souvent nécessaire pour les personnages principaux, ZRemesher ou Instant Meshes pouvant suffire pour les assets secondaires.

5. UV Mapping

Le mesh retopologisé est déplié en 2D pour recevoir les textures. Les coutures (seams) sont placées dans des zones peu visibles (intérieur des bras, dessous des pieds, arrière de la tête). La distribution du texel density doit être uniforme pour éviter les différences de résolution apparentes.

RizomUV et UV Layout sont les références du dépliage professionnel. Blender et Maya proposent des outils UV compétents mais moins spécialisés.

6. Baking

Les détails du high-poly sont transférés vers des texture maps appliquées au low-poly. Normal map, ambient occlusion, curvature, thickness : ces maps enrichissent visuellement le modèle sans coût polygonal.

Marmoset Toolbag 4 et Substance Painter sont les outils privilégiés. La configuration du cage et la gestion des hard edges requièrent une attention particulière pour éviter les artefacts de baking.

7. Texturing

Le texturing PBR donne vie au personnage. Substance Painter permet de peindre directement sur le modèle avec des smart materials, des générateurs procéduraux et des effets de vieillissement. Mari reste la référence pour les productions cinématographiques haute résolution.

Les textures de peau bénéficient de ressources spécialisées comme les scans XYZ, qui fournissent des détails de pores et de micro-relief d’un réalisme photographique.

8. Rigging et Skinning

Le squelette est créé et le mesh y est attaché. Un rig professionnel inclut des contrôleurs pour les animateurs, des systèmes IK/FK switchables, du facial rigging avec blend shapes ou joints, potentiellement des simulations de muscles et de vêtements.

Auto-Rig Pro (Blender), Advanced Skeleton (Maya), ou les systèmes propriétaires des studios structurent cette étape complexe. Le skinning — l’attribution des poids d’influence — reste l’une des tâches les plus chronophages et les plus difficiles à automatiser correctement.

9. Export et intégration

Le personnage finalisé est exporté vers sa destination : moteur de jeu, logiciel d’animation, renderer. Les formats varient selon le contexte : FBX reste le standard d’échange, GLTF gagne du terrain pour le web et le temps réel, USD s’impose dans les pipelines VFX.

Chaque plateforme a ses conventions : orientation des axes, échelle, structure des matériaux. Des scripts d’export automatisent ces conversions dans les pipelines matures.

Rendu, moteur temps réel et diffusion

Un personnage 3D n’existe pleinement que lorsqu’il est rendu — transformé en image ou en expérience interactive. Le choix du moteur de rendu et de la méthode de diffusion conditionne l’aspect final autant que la qualité de la modélisation.

Les moteurs temps réel : Unreal Engine et Unity

Unreal Engine 5 a redéfini les standards du rendu temps réel. Nanite virtualise la géométrie pour afficher des millions de polygones sans optimisation manuelle. Lumen calcule l’illumination globale en temps réel. MetaHumans démontrent un niveau de réalisme facial autrefois réservé aux rendus offline.

Pour les personnages, Unreal excelle dans les productions où le réalisme prime : jeux AAA, expériences VR, virtual production cinématographique. Son système de Control Rig et ses outils de motion capture live en font une plateforme d’animation à part entière.

Unity conserve des atouts spécifiques : légèreté, portabilité multiplateforme, écosystème d’assets. Son High Definition Render Pipeline (HDRP) produit des résultats visuellement comparables à Unreal pour les projets qui l’adoptent. La communauté mobile et AR/VR reste majoritairement sur Unity.

Les renderers de Blender : Cycles et Eevee

Blender propose deux moteurs de rendu aux philosophies opposées. Cycles est un path tracer physiquement réaliste : chaque rayon de lumière est simulé pour un rendu cinématographique, au prix de temps de calcul conséquents. Eevee est un renderer temps réel basé sur la rasterisation : résultats instantanés, mais approximations sur l’illumination globale et les réflexions.

L’évolution d’Eevee Next (Blender 4.x) a considérablement réduit l’écart qualitatif avec Cycles. Pour les artistes indépendants, la possibilité de préparer une scène en Eevee puis de lancer un rendu final en Cycles — le tout dans le même logiciel, avec les mêmes shaders — représente un avantage workflow considérable.

Présentation et turntable

La présentation d’un personnage pour portfolio ou validation client suit des conventions établies. Le turntable — rotation à 360° du personnage sur fond neutre — reste le format standard pour apprécier la modélisation sous tous les angles.

L’éclairage trois points (key, fill, rim) structure la plupart des présentations, enrichi d’un HDRI pour l’environnement. Des plans rapprochés sur le visage, les mains et les détails significatifs complètent le turntable. Marmoset Toolbag est devenu l’outil de référence pour ces beauty shots, grâce à son équilibre entre qualité et rapidité.

Les plateformes comme ArtStation et Sketchfab permettent une visualisation interactive directement dans le navigateur, démocratisant l’accès aux modèles 3D sans téléchargement.

Le personnage 3D comme langage visuel contemporain

Au-delà de sa dimension technique, le personnage 3D s’est constitué en langage visuel à part entière, porteur d’enjeux culturels, identitaires et esthétiques qui dépassent largement la sphère du divertissement.

L’avatar comme extension de soi

Dans les mondes virtuels — des MMORPGs aux plateformes sociales du métavers — le personnage 3D devient avatar, c’est-à-dire incarnation numérique de l’utilisateur. Le terme, emprunté au sanskrit (où il désigne les incarnations terrestres de Vishnou), a acquis dans l’univers numérique une portée existentielle.

L’avatar permet ce que le corps physique interdit : changer d’apparence, de genre, d’espèce ; incarner des fantasmes ; expérimenter des identités alternatives. Cette plasticité identitaire, source de libération pour certains, soulève des questions sur l’authenticité et la représentation de soi dans les espaces numériques.

Le marché des avatars personnalisés représente déjà plusieurs centaines de millions de dollars annuels, et les projections l’estiment à plus de 500 milliards d’ici 2030. Les jeunes générations investissent dans leur apparence virtuelle avec un sérieux comparable à celui accordé à la mode physique.

Standardisation et diversité

Les outils de création de personnages, en automatisant certains processus, ont paradoxalement contribué à une certaine standardisation des visages numériques. Les presets de MetaHuman, les morphes de Daz Studio, les outputs des générateurs IA présentent des biais esthétiques : des visages lisses, symétriques, conformes à des canons de beauté occidentaux et jeunes.

La question de la diversité dans les personnages 3D dépasse l’anecdotique. Quand les bases de données d’entraînement des IA surreprésentent certains phénotypes, quand les bibliothèques de morphes manquent de variations ethniques ou de représentations du handicap, le medium perpétue des exclusions.

Des initiatives émergent pour corriger ces biais : collections de scans diversifiés, morphes communautaires, critiques des defaults esthétiques des outils. Le character artist contemporain se trouve investi d’une responsabilité qui excède la pure technique.

Stylisation versus réalisme

La course au photoréalisme a longtemps structuré l’évolution de la 3D. Pourtant, les créations les plus marquantes de ces dernières années embrassent souvent la stylisation : les personnages de Spider-Verse, l’esthétique de Genshin Impact, les avatars expressifs de Fortnite.

La stylisation n’est pas un défaut de réalisme, mais un choix artistique à part entière. Elle permet une expressivité impossible au photoréaliste (déformations exagérées, silhouettes lisibles), évite la vallée de l’étrange, et vieillit souvent mieux que les tentatives de réalisme datées par les limitations technologiques de leur époque.

Le character artist doit maîtriser les deux registres : comprendre l’anatomie réelle pour mieux la transgresser, connaître les conventions du réalisme pour s’en émanciper consciemment.

L’IA et la question de l’auteur

L’émergence des générateurs IA pose une question fondamentale : qui est l’auteur d’un personnage généré à partir d’un prompt ? L’utilisateur qui formule la requête ? L’équipe qui a entraîné le modèle ? Les artistes dont les œuvres ont nourri les datasets d’entraînement ?

Ces questions, loin d’être théoriques, structurent déjà des contentieux juridiques et des débats éthiques dans l’industrie. Les politiques des studios divergent : certains interdisent l’usage d’assets générés par IA, d’autres l’encadrent strictement, d’autres encore l’intègrent pleinement à leur pipeline.

Pour l’artiste individuel, l’IA générative reconfigure le métier sans l’abolir. Les compétences de direction artistique, de retouche, d’intégration, de storytelling visuel restent humaines. Mais le profil du character artist évolue : moins d’exécution technique pure, davantage de curation, d’itération, de supervision.

Conclusion

Le personnage 3D occupe désormais une place singulière à l’intersection de disciplines autrefois cloisonnées. Il est objet technique, soumis aux contraintes du polycount et de l’edge flow ; œuvre artistique, porteuse d’intentions esthétiques et narratives ; vecteur identitaire, incarnant des utilisateurs dans des espaces virtuels en expansion ; enjeu économique, au cœur d’industries du divertissement qui pèsent des centaines de milliards.

Les voies pour créer ces personnages se sont multipliées. La modélisation polygonale classique coexiste avec le sculpting haute résolution, les outils paramétriques, le kitbashing, la génération IA. Aucune approche n’a rendu les autres obsolètes ; chacune trouve sa pertinence selon le contexte, le budget, l’intention artistique.

Le pipeline professionnel, avec ses étapes canoniques — concept, blockout, sculpt, retopo, UV, bake, texture, rig, export — structure un métier exigeant où la maîtrise technique ne dispense pas de la sensibilité artistique. Les outils évoluent, les fondamentaux demeurent : comprendre l’anatomie, respecter la topologie, servir l’animation, raconter par la forme.

L’irruption de l’IA redistribue les cartes sans abolir le jeu. Elle accélère certaines étapes, en démocratise d’autres, mais ne supprime ni le besoin de direction artistique, ni l’exigence de qualité, ni la responsabilité de représentation. Le character artist de demain sera probablement moins exécutant et davantage chef d’orchestre, supervisant des processus partiellement automatisés tout en conservant la main sur les décisions qui comptent.

Créer un personnage 3D, c’est finalement donner forme à une présence. Que cette présence habite un jeu vidéo, un film d’animation, un métavers ou une vitrine e-commerce, elle porte avec elle une part d’humanité — réelle ou simulée, réaliste ou stylisée, originale ou assemblée. Dans un monde où les images de synthèse colonisent tous les écrans, savoir fabriquer ces présences constitue un pouvoir créatif considérable.

Et ce pouvoir, malgré l’automatisation croissante, reste entre les mains de celles et ceux qui prennent le temps d’apprendre le métier.

Soyez le premier à commenter cet article !