Il y a encore cinq ans, évoquer la motion capture dans une conversation de créateur indépendant déclenchait systématiquement la même réaction : un soupir résigné suivi d’un « oui enfin bon, faut avoir les moyens de Ubisoft ». Les systèmes optiques professionnels comme Vicon ou OptiTrack restaient l’apanage des studios AAA, avec des budgets démarrant allègrement au-dessus des 50 000 €.

Et puis l’intelligence artificielle est passée par là. En 2026, la donne a complètement changé : une simple webcam, quelques algorithmes de pose estimation bien entraînés, et vous voilà capable de capturer vos mouvements pour les appliquer à vos personnages 3D. Gratuitement, dans certains cas.

Ce guide vous présente les solutions de motion capture sans costume disponibles aujourd’hui — des outils gratuits aux options plus avancées — pour que vous puissiez enfin donner vie à vos créations sans hypothéquer votre appartement.

Ce guide s’adresse aux animateurs 3D, développeurs de jeux indépendants, VTubers, créateurs de contenu et toute personne souhaitant animer des personnages 3D sans investir dans du matériel coûteux. Niveau technique requis : savoir ce qu’est un fichier FBX.

Comment fonctionne le mocap IA sans marqueurs ?

Avant d’analyser les outils, prenons deux minutes pour comprendre la magie qui opère derrière ces solutions. Contrairement aux systèmes traditionnels qui nécessitent des marqueurs réfléchissants ou des capteurs inertiels (IMU) cousus dans une combinaison, le mocap markerless repose sur la vision par ordinateur et l’apprentissage profond.

Pose Estimation

Technique d’IA qui analyse une image ou vidéo pour détecter et localiser les articulations du corps humain (épaules, coudes, hanches, genoux…) et en déduire la posture complète en 2D ou 3D.

Le principe est relativement simple à expliquer (beaucoup moins à implémenter) :

Capture vidéo

Vous filmez vos mouvements avec une webcam, un smartphone, ou même une caméra pro. L’essentiel est d’avoir une vue claire du corps.

Détection des keypoints

L’IA identifie les points clés de votre squelette : tête, épaules, coudes, poignets, hanches, genoux, chevilles… Certains systèmes détectent jusqu’à 133 points, incluant les doigts et le visage.

Reconstruction 3D

À partir des positions 2D détectées, des algorithmes reconstruisent la pose en 3D. C’est là que la qualité varie énormément selon les outils : estimer la profondeur depuis une seule caméra reste un défi.

Export et retargeting

Les données de mouvement sont exportées (généralement en FBX ou BVH) puis appliquées à votre personnage 3D dans Blender, Maya, Unreal Engine ou Unity.

Une seule caméra ne « voit » qu’un angle. Si vous tournez le dos, si un bras passe devant l’autre, l’IA doit « deviner » ce qui se passe. C’est pourquoi les systèmes dual-camera ou multi-camera offrent des résultats nettement supérieurs pour les mouvements complexes.

Les solutions gratuites : par où commencer

Bonne nouvelle : vous n’avez pas besoin de sortir votre carte bleue pour tester le mocap IA. Plusieurs outils proposent des versions gratuites parfaitement utilisables pour du prototypage, des projets personnels, ou simplement pour vous faire la main.

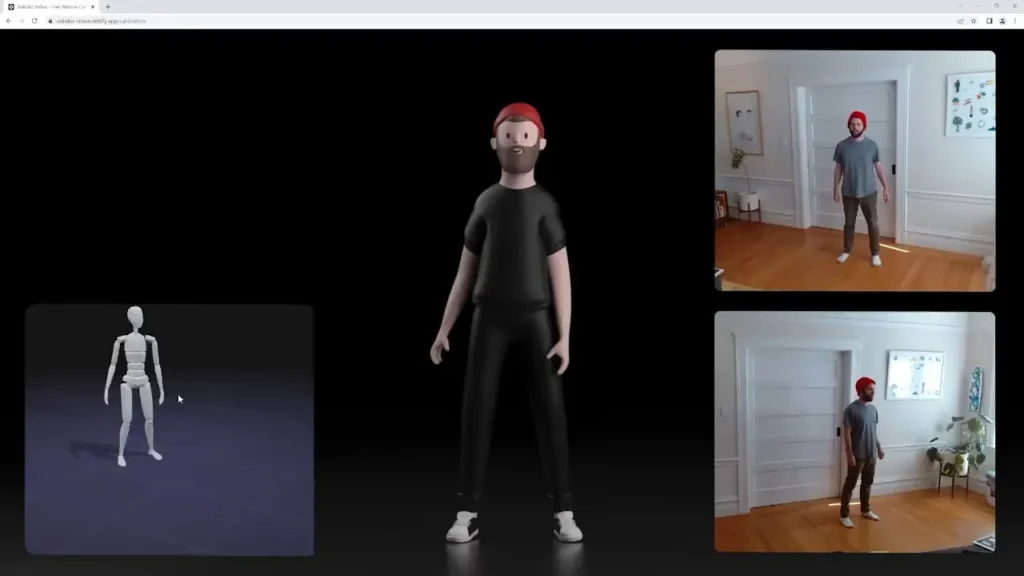

Rokoko Vision : le plus accessible

Rokoko Vision est devenu la référence pour les créateurs qui débutent en motion capture. L’entreprise danoise, connue pour ses combinaisons mocap abordables (le Smartsuit Pro II), propose un outil gratuit accessible directement depuis le navigateur.

Comment ça marche : Vous uploadez une vidéo ou vous enregistrez directement via votre webcam. Rokoko traite le tout dans le cloud (comptez 30-40 secondes pour 10 secondes de vidéo) et vous récupérez vos données d’animation.

Ce qui est gratuit :

- Capture single-camera illimitée

- Clips jusqu’à 15 secondes

- Export FBX/BVH compatible Blender, Unity, Unreal

- Accès à Rokoko Studio pour le nettoyage des données

Ce qui est payant (Rokoko Plus, ~240€/an) :

- Mode dual-camera pour une meilleure précision

- Durée d’enregistrement illimitée

- Live streaming vers les logiciels 3D

- Filtres avancés (foot locking, locomotion)

Rokoko Vision est le point d’entrée idéal. L’interface est limpide, les résultats sont honnêtes pour des mouvements simples, et vous pouvez tester sans créer de compte. Pour du previs ou des animations de personnages secondaires, c’est amplement suffisant.

DeepMotion Animate 3D : le plus complet en gratuit

DeepMotion Animate 3D existe depuis 2014 et reste l’un des pionniers du mocap IA. Leur offre gratuite est étonnamment généreuse et inclut des fonctionnalités qu’on ne trouve pas ailleurs sans payer.

Les points forts :

- Multi-person tracking : capturez jusqu’à 8 personnes simultanément depuis une seule vidéo

- Face et hand tracking inclus (les expressions faciales sont exportées en blendshapes)

- Rotoscope Pose Editor : corrigez manuellement les poses problématiques

- Physics simulation et foot locking automatiques

Le système de crédits : DeepMotion fonctionne avec des crédits (1 crédit = 1 seconde d’animation). Le compte gratuit offre des crédits limités, mais leur Free Animation Credit Program permet d’en regagner en labellisant vos animations (vous aidez à entraîner leur IA).

Autodesk Flow Studio : la puissance d’un studio VFX

Anciennement Wonder Studio, Autodesk Flow Studio a fait sensation lors de son lancement. Depuis son acquisition par Autodesk et le lancement d’un tier gratuit en août 2025, l’outil est devenu accessible à tous.

Flow Studio va bien au-delà du simple mocap : c’est un pipeline VFX complet qui :

- Extrait le motion capture de n’importe quelle vidéo

- Remplace automatiquement l’acteur par un personnage CG

- Génère le camera tracking, les clean plates, les masques alpha

- Exporte des scènes complètes compatibles Maya, Blender, Unreal (via USD)

Tier gratuit : Accès aux outils AI Mocap et Live Action avec des crédits limités. Les fonctionnalités avancées (Wonder Animation, Wonder Tools) restent réservées aux abonnements payants (à partir de 10$/mois pour Lite).

Flow Studio est particulièrement intéressant si votre workflow implique de remplacer des acteurs par des personnages 3D dans des plans live-action. Pour du mocap pur, les autres outils sont plus directs.

FreeMoCap : l’option open source

Pour les bidouilleurs et les chercheurs, The FreeMoCap Project propose une solution entièrement open source et gratuite. Développé par Jonathan Matthis de Northeastern University, ce projet vise à démocratiser le mocap de qualité recherche.

Particularités :

- Fonctionne en local (pas de cloud, pas de limite)

- Supporte les configurations multi-caméras avec des webcams USB basiques

- Addon Blender pour l’import direct

- Capture jusqu’à 133 keypoints (corps, mains, visage)

Le revers de la médaille : L’installation demande de mettre les mains dans le cambouis (Python, CUDA, calibration des caméras). Ce n’est pas un outil « plug and play », mais pour ceux qui veulent comprendre comment ça marche sous le capot, c’est une mine d’or.

FreeMoCap sur GitHub

Plask Motion : simple mais efficace

Plask Motion mise sur la simplicité. L’interface web permet d’uploader une vidéo, d’extraire le mouvement, et d’appliquer l’animation à un personnage importé — le tout sans quitter le navigateur.

Tier gratuit : 15 secondes de capture par jour. C’est peu, mais suffisant pour tester l’outil et capturer des mouvements courts.

Points forts :

- Éditeur de scène intégré avec éclairage et caméras

- Support VRM et MMD (parfait pour les projets anime/VTuber)

- Rendu vidéo directement dans l’outil

- Multi-person tracking

Remocapp : le mocap temps réel gratuit

Remocapp se distingue par son approche temps réel : contrairement aux autres qui nécessitent un upload et un traitement cloud, Remocapp capture et streame vos mouvements en direct vers votre logiciel 3D.

Configuration recommandée : deux webcams (une de face, une de côté) pour une meilleure triangulation. Le logiciel est gratuit, mais la précision dépend beaucoup de votre setup.

Le temps réel a un coût : la précision de Remocapp est inférieure aux solutions cloud qui prennent le temps d’analyser chaque frame. C’est un excellent outil pour du previs ou du streaming, moins pour de l’animation finale.

Les solutions payantes : quand passer au niveau supérieur

Les outils gratuits sont parfaits pour débuter, mais si vous produisez régulièrement du contenu animé ou travaillez sur des projets professionnels, les limitations deviennent vite frustrantes. Voici les options à considérer pour monter en gamme.

Move AI : la qualité pro accessible

Move AI s’est imposé comme LA référence pour le mocap markerless de qualité production. Leur technologie Gen 2, lancée en mars 2025, a marqué un tournant avec des modèles nettement plus précis.

Les modèles disponibles :

- s2 / s2-light : Single camera, le plus précis jamais développé pour cette configuration

- m2 / m2-xl : Multi-camera, qualité comparable aux systèmes optiques pro

- enhance : Correction et amélioration des données capturées via IA générative

Prix : Abonnement à partir de ~365$/an (Creator) avec des crédits mensuels. Le tier Pro (environ 7000$/an pour 2 acteurs) débloque les fonctionnalités avancées.

J’avais cherché un outil mocap pendant presque deux ans. Les combinaisons sont chères et les autres outils étaient imprécis, surtout pour les mains et les pieds. Mais la première fois que j’ai utilisé Move, j’ai été bluffé. Les données captées étaient PRÉCISES, même les doigts.

— Retour utilisateur, App Store

L’écosystème : Move AI propose des apps iOS pour la capture (Move One pour single-cam, Move Multi-Cam pour les configurations avancées) et un portail web pour le traitement. L’export se fait en FBX, BVH ou USD.

Meshcapade : précision scientifique

Meshcapade vient du monde académique (les créateurs ont publié des papers fondateurs sur SMPL, le modèle de corps humain paramétrique). Leur approche est plus technique mais offre une précision remarquable.

Points différenciants :

- Reconstruction de mesh corporel complet (pas seulement le squelette)

- Plugins Unreal Engine pour l’intégration directe

- Orienté recherche et studios VFX haut de gamme

Pricing : À partir de ~99€/mois, le plus cher du marché mais avec une qualité qui le justifie pour certains workflows.

Radical : l’alternative européenne

Radical propose une solution de mocap IA avec un focus sur la fluidité des animations. Leur technologie produit des mouvements particulièrement « smooth », réduisant le travail de cleanup.

Tier gratuit : 1 heure de traitement incluse, puis abonnement. La qualité est au niveau des meilleurs, mais les limites du free tier sont strictes.

Tableau comparatif des solutions

Pour vous aider à choisir, voici un récapitulatif des principales solutions :

| Solution | Prix | Temps réel | Multi-cam | Face/Hands | Idéal pour |

|---|---|---|---|---|---|

| Rokoko Vision | Gratuit / 240€/an | ❌ (upload) | ✅ (payant) | ❌ / ❌ | Débutants, previs |

| DeepMotion | Freemium (crédits) | ❌ | ❌ | ✅ / ✅ | Projets complets |

| Flow Studio | Gratuit / 10-150$/mois | ❌ | ❌ | ✅ / ✅ | VFX, remplacement acteur |

| FreeMoCap | Gratuit (open source) | ❌ | ✅ | ✅ / ✅ | Recherche, bidouilleurs |

| Plask | Gratuit / 18-50$/mois | ❌ | ❌ | ❌ / ❌ | Projets anime/VRM |

| Remocapp | Gratuit | ✅ | ✅ (2 webcams) | ✅ / ❌ | Streaming, previs live |

| Move AI | 365$/an et + | ✅ (avec app) | ✅ | ❌ / ✅ | Production pro |

| Meshcapade | ~99€/mois | ❌ | ✅ | ✅ / ✅ | VFX haut de gamme |

Optimiser vos captures : les bonnes pratiques

Quel que soit l’outil choisi, la qualité de vos résultats dépend énormément de vos conditions de capture. Voici les règles d’or pour obtenir des données exploitables.

L’éclairage : votre meilleur allié

L’IA détecte votre corps grâce au contraste. Un mauvais éclairage = des keypoints perdus = des mouvements aberrants. Privilégiez :

- Un éclairage uniforme sans zones d’ombre marquées

- Évitez le contre-jour (fenêtre derrière vous = catastrophe)

- La lumière naturelle fonctionne bien, mais un ring light ou softbox est encore mieux

Le fond : contraste maximum

Portez des vêtements qui contrastent avec votre arrière-plan. Fond blanc + t-shirt blanc = échec assuré. L’idéal :

- Vêtements ajustés (les vêtements amples masquent les articulations)

- Couleurs unies, pas de motifs complexes

- Fond neutre et dégagé

Évitez les shorts et t-shirts si vous voulez capturer les coudes et genoux avec précision. Les manches longues et pantalons permettent à l’IA de mieux « voir » les articulations.

Le cadrage : tout le corps, tout le temps

Assurez-vous que votre corps entier reste dans le cadre pendant toute la capture. Les points coupés sont interpolés par l’IA, ce qui introduit des erreurs.

- Laissez une marge autour de votre silhouette

- Caméra stable (trépied fortement recommandé)

- Angle frontal ou légèrement de trois-quarts pour le single-cam

Les mouvements : clarté et lisibilité

L’IA a du mal avec :

- Les mouvements trop rapides (motion blur)

- Les auto-occultations (bras croisés, accroupi, etc.)

- Les interactions avec des objets (les objets ne sont pas trackés)

Pour des animations complexes, préférez les configurations multi-caméras ou planifiez vos prises pour minimiser les angles morts.

Intégration avec Blender

Blender reste le logiciel de choix pour la majorité des créateurs indépendants. Bonne nouvelle : tous les outils mentionnés exportent dans des formats compatibles.

Workflow type

Export depuis l'outil mocap

Téléchargez votre animation en FBX ou BVH. Préférez FBX si vous avez le choix (meilleure compatibilité).

Import dans Blender

File > Import > FBX. Cochez « Automatic Bone Orientation » pour éviter les problèmes de rotation.

Retargeting

Si votre rig cible est différent du squelette mocap, utilisez l’addon Rokoko Studio Live ou Auto-Rig Pro pour le retargeting.

Cleanup

Nettoyez les glitches (foot sliding, tremblements) avec le Graph Editor. Des addons comme Butterworth Filter peuvent automatiser une partie du travail.

Addons utiles

- Rokoko Studio Live for Blender : streaming temps réel et import facilité

- Auto-Rig Pro : retargeting avancé et rigging automatique

- FreeMoCap Blender Addon : import direct des captures FreeMoCap

- BlendArMocap : mocap directement dans Blender via MediaPipe

Mocap IA vs combinaison : le match

La question revient souvent : « Avec tous ces progrès, est-ce que les combinaisons mocap sont obsolètes ? »

La réponse courte : non, pas encore. Mais l’écart se réduit chaque mois.

Où l’IA gagne

- Coût d’entrée : 0€ vs 1500-3000€ pour une combinaison

- Portabilité : Capturez n’importe où avec un smartphone

- Pas de setup : Pas de calibration, pas de capteurs à recharger

- Capture de n’importe qui : Pas besoin de faire enfiler une combi à votre acteur

Où les combinaisons gardent l’avantage

- Précision : Les systèmes inertiels (type Smartsuit Pro II ou Xsens) restent plus fiables

- Occultation : Aucun problème quand le corps est partiellement caché

- Temps réel stable : Latence constante et prévisible

- Capture des doigts : Avec des gants dédiés, bien supérieure à l’IA

L’avenir semble être à l’hybridation. Des entreprises comme Rokoko combinent déjà leurs combinaisons avec leur mocap IA pour offrir le meilleur des deux mondes. Le mocap IA pour le previs, la combinaison pour la capture finale.

L’avenir du mocap IA : ce qui arrive

Le marché du mocap IA évolue à une vitesse folle. Voici les tendances à surveiller :

Text-to-motion

Pourquoi capturer un mouvement quand vous pouvez le décrire ? Des outils comme Kinetix ou le SayMotion de DeepMotion permettent de générer des animations à partir d’un simple prompt texte. « Un personnage qui fait un salto arrière puis salue » → animation générée.

Mocap on-device

Avec les puces Neural Engine d’Apple et les NPU des nouveaux processeurs, le traitement mocap se fait de plus en plus directement sur le téléphone, sans passer par le cloud. Moins de latence, plus de confidentialité.

Qualité optique à prix IA

Les modèles Gen 2 de Move AI commencent à rivaliser avec les systèmes optiques professionnels. D’ici quelques années, la distinction pourrait devenir floue pour la majorité des usages.

FAQ : vos questions fréquentes

Quelle résolution vidéo pour de bons résultats ?

720p minimum, 1080p recommandé. Au-delà, le gain est marginal et le temps de traitement augmente. Privilégiez 30fps minimum, 60fps si possible pour les mouvements rapides.

Peut-on capturer plusieurs personnes ?

Oui, DeepMotion supporte jusqu’à 8 personnes, Move AI jusqu’à 20 (avec m2-xl). Attention cependant : les personnes ne doivent pas se chevaucher trop longtemps dans le cadre.

Les outils gratuits sont-ils utilisables commercialement ?

En général, oui. Rokoko Vision, DeepMotion et Plask permettent l’usage commercial même sur leurs tiers gratuits. Vérifiez les CGU spécifiques, notamment pour Autodesk Flow Studio qui utilise vos contenus pour entraîner ses modèles.

Quel outil pour du VTubing ?

Remocapp pour le temps réel avec deux webcams, ou Plask pour son support natif VRM. Le tracking facial nécessitera un outil supplémentaire (iPhone avec ARKit, ou solution dédiée).

Le mocap IA fonctionne-t-il pour les animaux ?

La plupart des outils sont optimisés pour le corps humain. Pour les animaux, il faudra vous tourner vers des solutions spécialisées ou des réseaux de type DeepLabCut (plus technique).

Quelle est la précision par rapport au mocap traditionnel ?

Une étude de 2025 dans le Journal of Sports Sciences a comparé Theia3D (markerless) à des systèmes à marqueurs pour du baseball haute vitesse. Résultat : précision suffisante pour la plupart des métriques biomécaniques, avec quelques écarts sur les angles extrêmes. Pour de l’animation de personnages, la différence est rarement visible à l’œil nu.

Conclusion : lancez-vous !

Le motion capture n’a jamais été aussi accessible. Que vous soyez un animateur indépendant, un développeur de jeux solo, ou simplement curieux, les barrières à l’entrée ont quasiment disparu.

Mon conseil : commencez par Rokoko Vision pour vous faire la main. C’est gratuit, ça prend 5 minutes, et vous aurez immédiatement une idée de ce que ces outils peuvent faire. Ensuite, explorez DeepMotion si vous avez besoin du tracking facial, ou Move AI si vous passez à la production sérieuse.

Le mocap IA ne remplace pas (encore) complètement les solutions traditionnelles, mais pour 90% des usages créatifs, c’est devenu la solution évidente. Alors filmez-vous en train de danser dans votre salon, uploadez la vidéo, et regardez la magie opérer.

Votre personnage 3D n’attend que vos mouvements.

Pour aller plus loin, consultez nos articles sur l’intégration du mocap dans Blender et notre comparatif des combinaisons mocap si vous envisagez d’investir dans du matériel dédié.

Soyez le premier à commenter cet article !