Les utilisateurs payants de ChatGPT remarquent une baisse de la qualité des réponses de GPT-4 ces dernières semaines, ce qui soulève la question des actions entreprises par OpenAI. Depuis son lancement en mai 2023, le modèle de langage GPT-4 semble-t-il avoir perdu en pertinence ? Sur les réseaux sociaux, de nombreux utilisateurs rapportent une diminution de la qualité des réponses de l’IA, malgré une production de texte plus rapide, mais avec des incohérences plus fréquentes. Certains utilisateurs critiquent spécifiquement les erreurs régulières de GPT-4 lorsqu’il génère du code, ce qui n’était pas le cas auparavant.

Le 20 mai dernier, une discussion a émergé sur Twitter. Laura Wendel, une ingénieure logicielle, s’est interrogée en disant : « Est-ce que GPT-4 a été lobotomisé ? » Selon elle, ChatGPT répond plus rapidement aux requêtes, mais ses performances semblent nettement moins bonnes qu’auparavant, avec des problèmes tels que le non-respect des instructions et des erreurs de codage évidentes. Son expérience personnelle a rapidement été confirmée par de nombreux témoignages allant dans le même sens, bien qu’il convienne de rester prudent quant à l’effet placebo.

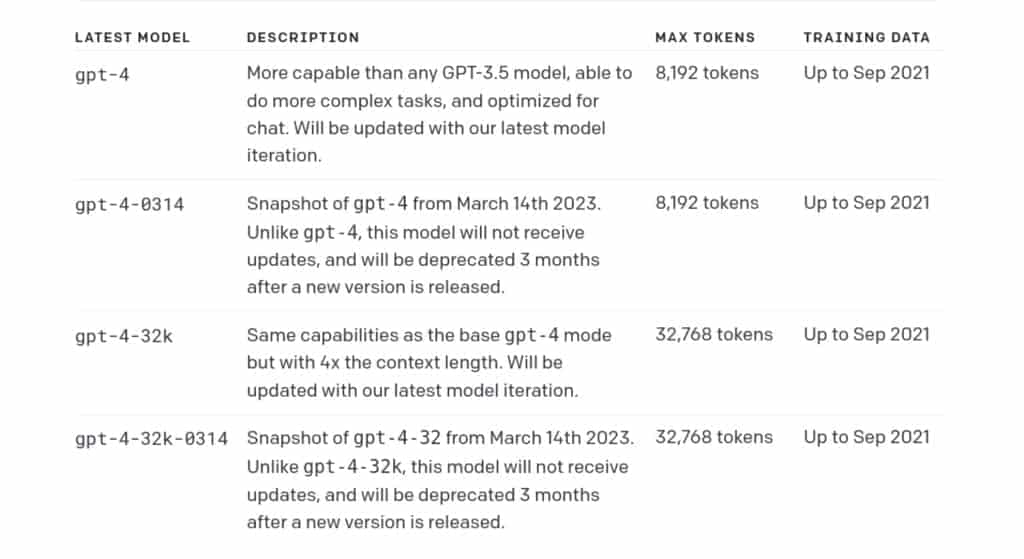

Est ce que la dernière version est stable ?

Les abonnés à ChatGPT Plus bénéficient d’un choix entre différents agents conversationnels. Ils peuvent opter pour la version GPT-3.5, qui utilise le modèle « gpt-3.5-turbo » pour des réponses rapides, ou choisir la version GPT-4, qui utilise le tout dernier modèle de langage d’OpenAI. La mise à jour du 12 mai a également introduit des modes optionnels, permettant d’effectuer des recherches sur le web ou d’utiliser des plugins.

GPT-4, qui était initialement impressionnant lors de son lancement, a été critiqué pour sa baisse de performance ces dernières semaines, au point que GPT-3.5 le surpasse sur certaines questions.

Nos propres tests basés sur des prompts de logique du New York Times montrent que l’efficacité des réponses produites le 22 mai n’est pas différente de celle obtenue lors du lancement de GPT-4 en mars, selon nos confrères. Cependant, une différence notable est que l’IA semble moins encline à répondre à certaines requêtes très techniques, telles que l’autocompression des conversations. De plus, la modération semble être plus efficace et difficile à contourner, ce qui suggère qu’OpenAI a pris des mesures pour empêcher son IA de répondre à certaines questions problématiques.

Quelles sont les raisons derrière ces (potentiels) changements ?

OpenAI pourrait avoir limité artificiellement les capacités de son IA afin de perfectionner ses modèles et réduire les risques juridiques. Cependant, il reste à prouver si ces changements récents ont réellement eu lieu, car les réseaux sociaux peuvent parfois amplifier les informations sans qu’il y ait eu de modifications majeures. Il est également possible que les développeurs aient utilisé des techniques d’apprentissage par renforcement à partir du feedback humain pour ajuster les réponses du système, ce qui peut parfois affecter les performances de l’IA sur certains sujets.

Malgré les affirmations de ChatGPT selon lesquelles son système n’a pas évolué depuis septembre 2021, il est évident que des changements ont été effectués. Toutefois, il est peu probable que l’utilisation d’un modèle alternatif moins performant ait été la cause de ces modifications, car les experts du domaine l’auraient certainement détecté plus tôt. Il est donc préférable de ne pas tirer de conclusions hâtives et de rester prudent dans l’analyse de la situation.

Les nouveaux modèles d’IA deviennent moins prédictibles.

Dans sa documentation, OpenAI souligne que ses modèles sont « non déterministes », ce qui signifie que des entrées identiques peuvent générer des sorties différentes. En d’autres termes, il est pratiquement impossible d’obtenir la même réponse à une question posée plusieurs fois. La gestion du déterminisme et de la créativité des réponses est effectuée par le biais de la « température », une variable intégrée à l’API d’OpenAI. Les récents changements pourraient résulter d’une modification de cette variable au sein de l’interface web de ChatGPT.

Malgré l’absence de réponse officielle d’OpenAI, des scientifiques de l’unité IA de Microsoft ont constaté une régression significative des progrès de GPT-4 sur une période d’un an. La version initiale utilisée par les chercheurs, bien qu’elle ne soit pas publique, était plus avancée que celle présentée ultérieurement par OpenAI en mars. Cette régression pourrait être expliquée par une réduction artificielle des capacités de l’IA, dans le but de la préparer pour une utilisation grand public avant sa sortie officielle. La réaction d’OpenAI aux récentes remarques des utilisateurs concernant GPT-4 reste en attente à ce jour.

Soyez le premier à commenter cet article !